Quando l’intelligenza artificiale osserva, riconosce e deduce

I nuovi modelli OpenAI leggono le immagini, ma la loro capacità di geolocalizzazione solleva interrogativi sulla privacy.

L’intelligenza artificiale ora riconosce luoghi da una semplice foto, ma le implicazioni etiche sono tutt’altro che banali.

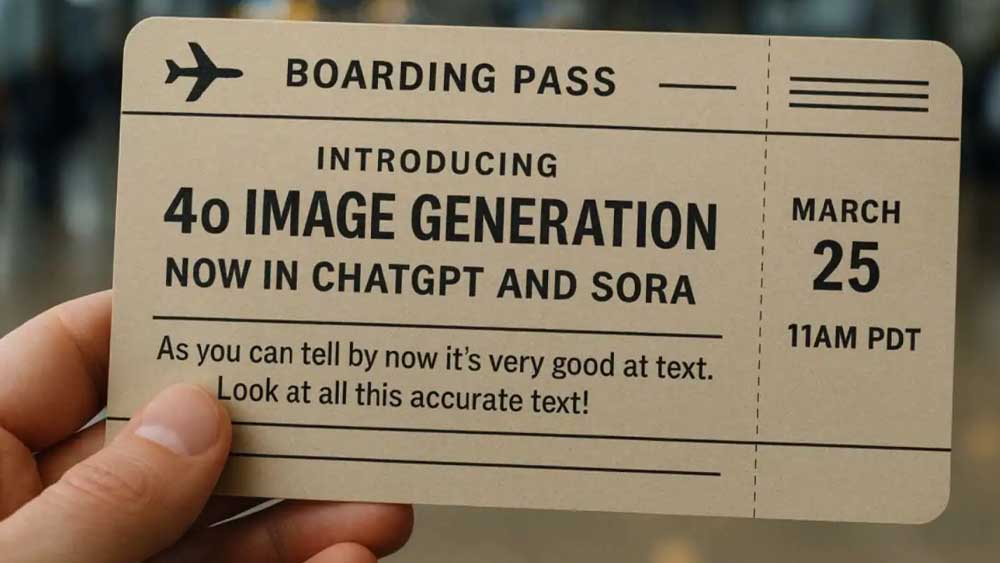

OpenAI ha recentemente annunciato l’introduzione dei modelli O3 e O4-Mini, versioni potenziate di intelligenza artificiale che arricchiscono l’esperienza degli utenti a pagamento su ChatGpt. La grande novità? L’abilità di "ragionare" anche attraverso le immagini. Questi modelli sono in grado di interpretare fotografie caricate dagli utenti e trarne conclusioni complesse, persino quando la qualità dell’immagine è bassa o i dati interni sono stati rimossi.

Geolocalizzazione visiva, quando una foto vale più di mille parole

Nel giro di poche ore dal lancio, gli utenti più curiosi hanno iniziato a testare la nuova funzione, caricando foto anonime e chiedendo al chatbot dove fossero state scattate. Il risultato? In molti casi, risposte corrette al 100%, come raccontano alcune testimonianze sul social X. A colpire è la precisione: il modello O3 riesce a riconoscere città, monumenti, locali pubblici e persino piccoli dettagli urbanistici, anche in assenza di metadati o indizi evidenti.

Privacy sotto la lente, tra potenziale utilità e rischi inaspettati

Se da un lato la capacità del chatbot di leggere immagini e dedurre informazioni può avere molteplici applicazioni – dall’assistenza turistica all’analisi di scenari complessi – dall’altro solleva importanti riflessioni sulla privacy. OpenAI ha spiegato al sito TechCrunch di aver addestrato i modelli a rifiutare richieste legate a dati personali o sensibili, integrando sistemi di sicurezza per evitare l’identificazione degli individui.

OpenAI rassicura, ma il dibattito resta aperto

"Monitoriamo attivamente l’utilizzo dei nostri strumenti e interveniamo in caso di abusi", afferma OpenAI, sottolineando come le politiche aziendali siano orientate a prevenire comportamenti scorretti. Tuttavia, il fatto che il chatbot riesca a individuare con esattezza un luogo a partire da pochi dettagli visivi – anche quando la memoria è disabilitata e i dati ’Exif’ eliminati – lascia spazio a perplessità legittime.

Oltre la potenza, serve una nuova consapevolezza digitale

L’evoluzione dell’intelligenza artificiale visiva apre scenari affascinanti, ma rende urgente una riflessione collettiva su cosa sia opportuno chiedere e ottenere da questi strumenti. Se oggi l’IA riesce a "vedere", domani potrebbe riuscire a "intuire" in modo sempre più sofisticato. E senza un’etica ben definita, il rischio è quello di entrare in una zona grigia dove potenzialità e pericoli si confondono.

Dalla tecnologia alla società, una nuova responsabilità condivisa

Non si tratta solo di algoritmi sempre più intelligenti, ma di una sfida culturale. Le immagini non sono più semplici file digitali, ma diventano fonti di conoscenza che i chatbot possono interpretare con crescente precisione. Di fronte a tutto questo, la vera domanda non è quanto può fare l’intelligenza artificiale, ma quanto è giusto permetterle di fare.

19 Aprile 2025

© team icoe, editoriale blozine

blozine editoriale no-profit della

Centro studi su innovazione, comunicazione ed etica.

Copywriters

Francesca S., Matteo R., Laura A., Antonella B., Giorgio F., Anna C., Miriam M., Stefano G., Adele P. e Francesca N.

Chi siamo

iscriviti sulla nostra pagina Facebook e non perderai nessuna notizia!